Esta semana, um vídeo produzido pelo influenciador Felca ganhou o ambiente digital e o debate público no Brasil ao denunciar o fenômeno da “adultização” de crianças e jovens.

Em cerca de 50 minutos, Felca apresenta conteúdos veiculados nas redes em que crianças e jovens são estimulados a agirem como adultos. Em outros casos, os canais e postagem exploram a sexualização de menores, gerando engajamento e acionando redes de pedofilia online.

O experimento realizado Felca repete um método aplicado por pesquisadores em comunicação que investigam os impactos do uso das redes sociais, em especial como a estrutura tecnológica orienta os conteúdos para os usuários.

Ao clicar em um conteúdo do seu interesse, o usuário passa a receber recomendações dos algoritmos. O problema é que esse processo de identificação das preferências do usuário produz um mergulho em canais e conteúdos cada vez mais obscuros.

Esse processo é conhecido como a “toca do coelho” (do inglês, “rabbit hole”). Mais do que gerar uma sequência de vídeos ou conteúdos, esse fenômeno, na verdade, acaba por expor ou direcionar material progressivamente mais extremo.

No contexto de plataformas, como o YouTube, a “toca do coelho” se manifesta quando usuários que acessam um vídeo de um determinado tipo, como conteúdo político de direita, mas recebem sucessivamente novas recomendações com conteúdo semelhante ou mais radical. É por aí que o usuário é levado para uma imersão profunda em uma bolha ideológica.

Radicalização política e o impacto algorítmico

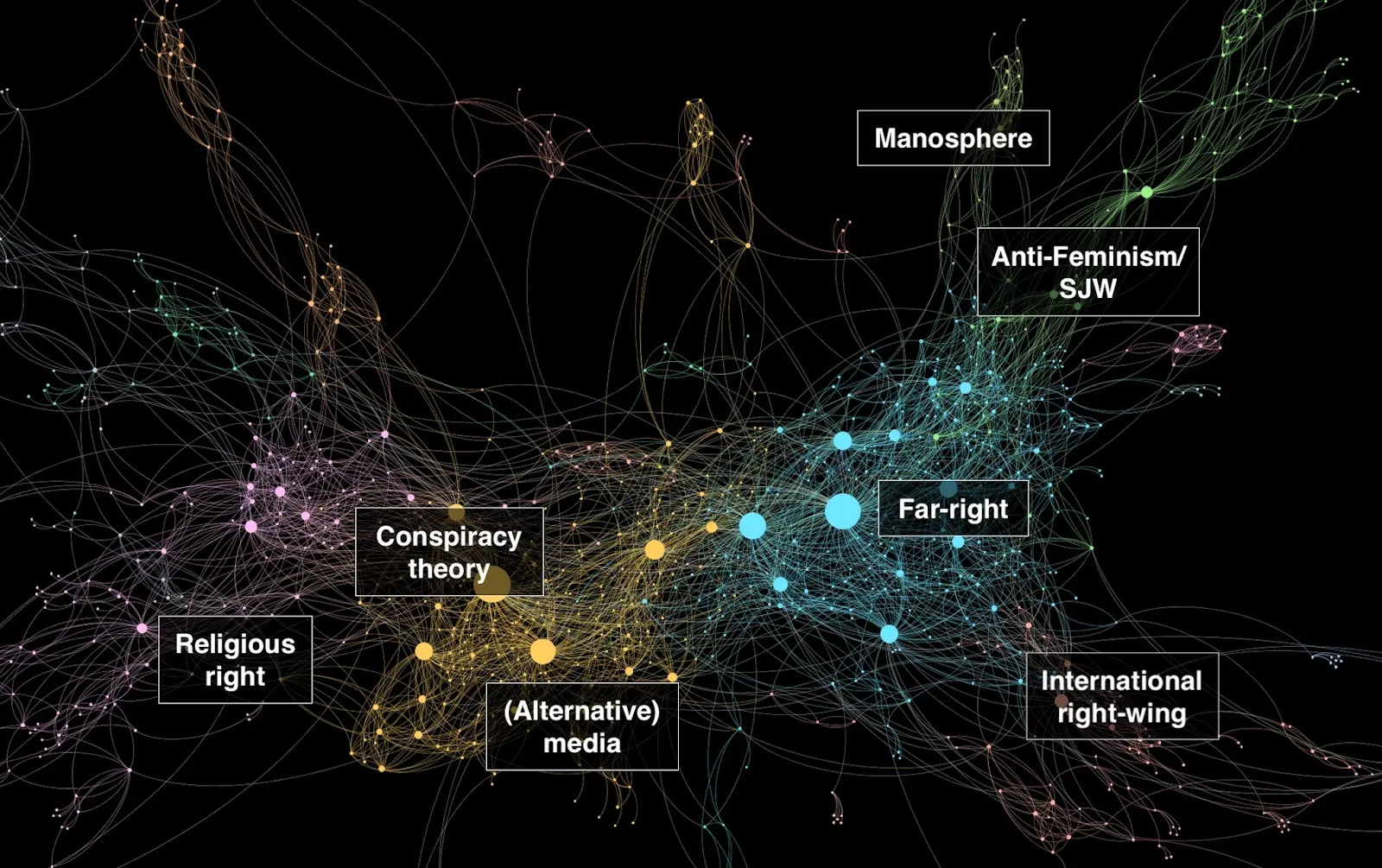

Um dos principais achados do fenômeno da “toca do coelho” é o potencial para a radicalização política. Os primeiros estudos publicados ainda em 2014 avaliaram esse fenômeno em canais de extrema-direita em inglês e alemão.

O estudo demonstrou que os usuários são consistentemente direcionados para conteúdo de extrema-direita da mesma categoria ou conteúdo de extrema-direita relacionado de uma categoria diferente, sendo improvável recebam conteúdos de não-extrema-direita.

Para os pesquisadores, a imersão em espaços da extrema-direita do YouTube seria uma coprodução entre o conteúdo gerado pelos usuários e a arquitetura do sistema de recomendação das redes.

Posteriormente Kaiser e Rauchfleisch identificaram que os algoritmos de recomendação do YouTube contribuem ativamente para a formação de uma “bolha de filtro” de extrema-direita no EUA, agrupando canais conservadores e de teorias da conspiração. Esse modelo tornava o conteúdo extremista acessível para um grande número de usuários, bastando um ou dos cliques.

Conteúdo impróprio para crianças: um estudo de caso brasileiro

A “toca do coelho” também se revelou um vetor para a exposição a conteúdo impróprio para crianças. Em uma pesquisa focada originalmente em mapear a “YouTube e a esfera pública brasileira”, Jonas Kaiser e Adrian Rauchfleisch, juntamente com Yasodora Córdova, acidentalmente caíram em uma “toca do coelho” algorítmica que os levou a comunidades de canais sexualmente sugestivos, incluindo vídeos de menores e crianças.

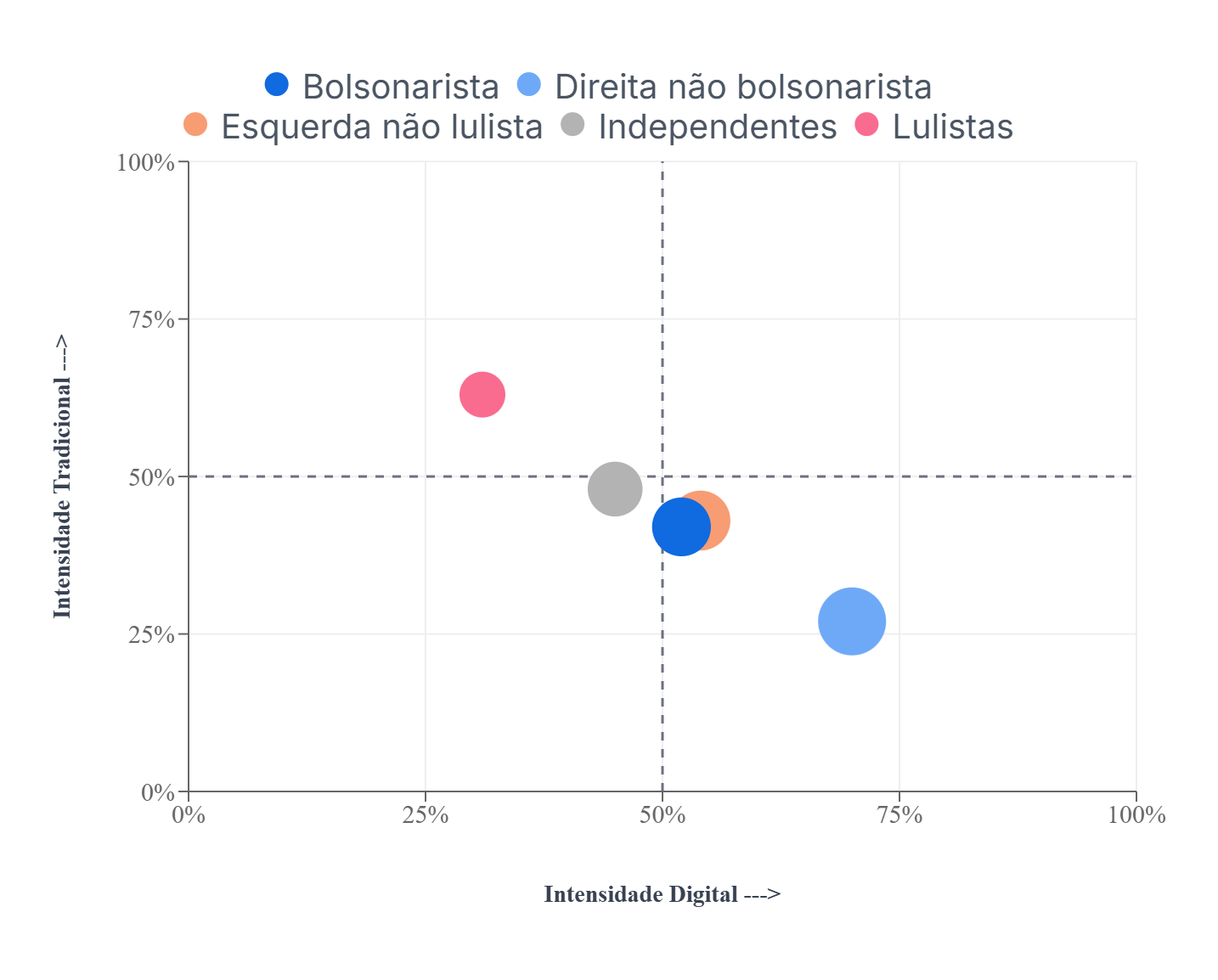

O objetivo inicial da pesquisa era entender a estrutura das comunidades e canais proeminentes no Brasil, uma das maiores democracias do mundo com alta participação de youtubers na política.

Para isso, os pesquisadores utilizaram a função de “canais relacionados” do YouTube, começando com uma lista de 451 canais políticos, expandindo essa lista em cinco etapas até um total de 12.341 canais.

Ao analisar a estrutura da rede, eles identificaram comunidades de conteúdo político, canais mainstream, teorias da conspiração, esotéricos e, surpreendentemente, canais sexualmente sugestivos.

A explicação para esse sistema de recomendação que acaba levando à “toca do coelho” está no modelo de negócio das redes. Os algoritmos são construídos para ampliar a permanência de tela do usuário, relacionando cada vez mais canais e conteúdos que supostamente estejam alinhados com as preferências de quem utiliza a rede. Isso ocorre independentemente do conteúdo veículos pelos canais e publicadores.

Referências

Siga @redem.inct no Instagram e @redem_inct no X para saber mais sobre os estudos realizados por nossos pesquisadores!

Fábio Vasconcellos

Doutor em Ciência Política pelo IESP (2013) e mestre em Comunicação Social pela UERJ (2008). Professor associado da Faculdade de Comunicação UERJ. Temas de interesse: Comportamento Eleitoral; Comunicação Política; Eleições; Opinião Pública; Analise de Dados.